فهرست مطالب

دورههای آموزشی

برنامه نویسی مدرن، از مبانی تا توسعه وب و وب اپلیکیشن با “هوش مصنوعی” و “وایب کدینگ”

دوره جنگجوی پرامپت نویسی (از کلمات تا معجزه)

خطرات هوش مصنوعی: از دیپفیکهای ترسناک تا سونامی اخبار جعلی

فهرست مطالب

تصور کنید یک روز صبح از خواب بیدار میشوید و ویدیویی از نخستوزیر کشورتان را در شبکههای اجتماعی میبینید که در حال اعلام جنگ با یک کشور همسایه است. صدایش خود اوست، چهرهاش خود اوست، حرکاتش کاملاً طبیعی به نظر میرسد. وحشت و هرجومرج همهجا را فرا میگیرد. بازار بورس سقوط میکند، مردم به خیابانها میریزند و دنیا در آستانه یک فاجعه قرار میگیرد. اما چند ساعت بعد، دفتر نخستوزیری با اضطراب اعلام میکند که این ویدیو کاملاً ساختگی بوده و هرگز چنین سخنانی گفته نشده است. به دنیای دیپفیک (Deepfake) خوش آمدید؛ جایی که دیگر نمیتوانید به چشمها و گوشهای خود اعتماد کنید.

این سناریو شاید امروز کمی اغراقآمیز به نظر برسد، اما تکنولوژی لازم برای اجرای آن همین حالا در دستان ماست. هوش مصنوعی (AI)، این پدیده شگفتانگیز که قول داده بود زندگی ما را متحول کند، در حال نشان دادن روی دیگر و تاریک خود است. ما در این مقاله نمیخواهیم شما را از تکنولوژی بترسانیم. هدف ما این است که مانند یک راهنمای دلسوز، شما را به سفری در اعماق این دنیای پیچیده ببریم و با زبانی ساده و روان، خطراتی را که در کمین نشستهاند، به شما نشان دهیم. این مقاله برای همه است؛ از دانشآموزی که برای اولین بار با مفهوم هوش مصنوعی آشنا میشود تا پدر و مادری که نگران محتوای مصرفی فرزندانشان در اینترنت هستند. پس با ما همراه باشید تا بفهمیم چگونه شمشیر دولبه هوش مصنوعی میتواند به جای ساختن، ویران کند و مهمتر از آن، یاد بگیریم که چگونه سپر دفاعی خود را در برابر این تهدیدات بالا ببریم.

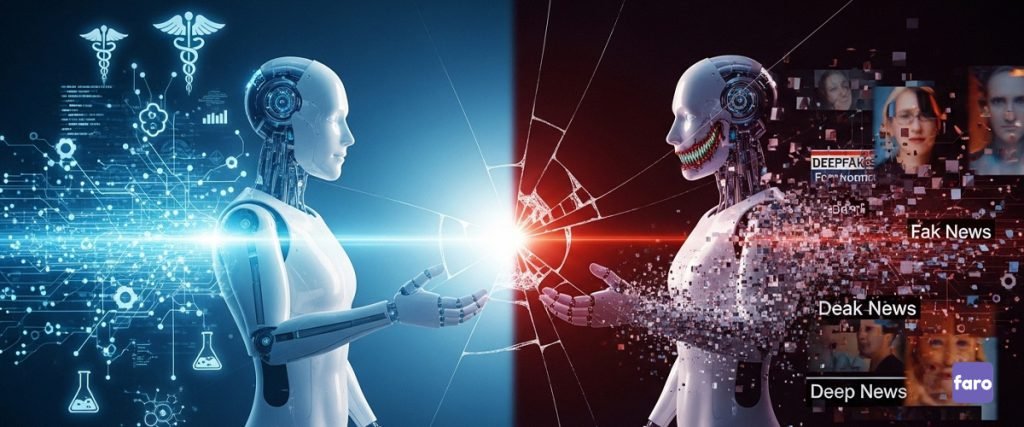

هوش مصنوعی، فرشته یا هیولا؟ شمشیری که هر دو لبهاش تیز است

قبل از اینکه به بخشهای ترسناک ماجرا بپردازیم، بیایید کمی با خود هوش مصنوعی آشتی کنیم. هوش مصنوعی در سادهترین تعریف، تلاشی است برای اینکه کامپیوترها بتوانند مانند انسانها فکر کنند، یاد بگیرند و تصمیم بگیرند. همین حالا هم زندگی ما را به شکلهای مثبتی تغییر داده است. از الگوریتمهایی که در گوشیهای هوشمندمان بهترین مسیر را برای رسیدن به مقصد پیشنهاد میدهند، تا سیستمهای پیشرفتهای که به پزشکان در تشخیص سرطان کمک میکنند؛ همه اینها هدایایی از طرف هوش مصنوعی هستند.

این فناوری پتانسیل حل بزرگترین مشکلات بشریت را دارد: درمان بیماریها، مبارزه با تغییرات اقلیمی، و حتی سفر به سیارات دیگر. اما دقیقاً همین قدرت خارقالعاده است که آن را خطرناک میکند. مانند آتشی که هم میتواند ما را گرم کند و هم خانهمان را بسوزاند، هوش مصنوعی نیز ابزاری است که نحوه استفاده از آن، سرنوشت ما را تعیین خواهد کرد. متأسفانه، همیشه افرادی هستند که از قدرتمندترین ابزارها برای اهداف مخرب استفاده میکنند. در ادامه، با دو مورد از خطرناکترین فرزندان ناخلف هوش مصنوعی آشنا میشویم: دیپفیک و اخبار جعلی.

بخش اول: دیپفیک؛ وقتی حقیقت در برابر چشمانتان جعل میشود

دیپفیک (ترکیبی از "یادگیری عمیق" و "جعل")، یکی از نگرانکنندهترین کاربردهای هوش مصنوعی است. این فناوری به زبان ساده، به ما اجازه میدهد تا چهره یا صدای یک شخص را با شخص دیگری در یک ویدیو یا فایل صوتی تعویض کنیم، آن هم به شکلی که تشخیص آن تقریباً غیرممکن باشد.

دیپفیک چگونه متولد میشود؟ یک نبرد خلاقانه در دنیای دیجیتال

برای درک بهتر، یک کارگاه مجسمهسازی را تصور کنید. در این کارگاه دو هنرمند حضور دارند. هنرمند اول، «جاعل»، سعی میکند یک مجسمه کپی دقیق از یک اثر معروف بسازد. هنرمند دوم، «کارآگاه»، وظیفهاش این است که به مجسمه نگاه کند و بگوید آیا اصل است یا تقلبی. در ابتدا، جاعل کارش خوب نیست و کارآگاه به راحتی تقلب او را تشخیص میدهد. اما جاعل از اشتباهاتش درس میگیرد و تلاش میکند مجسمه بعدی را بهتر بسازد. این چرخه هزاران بار تکرار میشود. با هر بار تلاش، جاعل ماهرتر و ماهرتر میشود تا جایی که دیگر کارآگاه هم نمیتواند تفاوت بین مجسمه اصلی و تقلبی را تشخیص دهد.

فناوری پشت دیپفیک که به آن شبکههای مولد تخاصمی (GANs) میگویند، دقیقاً همینطور کار میکند. دو شبکه هوش مصنوعی با هم رقابت میکنند: یکی سعی میکند ویدیوهای جعلی بسازد (جاعل) و دیگری سعی میکند آنها را تشخیص دهد (کارآگاه). این رقابت بیوقفه باعث میشود که کیفیت ویدیوهای جعلی روزبهروز بهتر و واقعیتر شود.

خطرات واقعی دیپفیک: فراتر از یک شوخی اینترنتی

شاید در ابتدا دیپفیکها برای سرگرمی و ساختن ویدیوهای خندهدار از بازیگران مشهور استفاده میشدند، اما امروز به یک سلاح قدرتمند تبدیل شدهاند. خطرات آن را میتوان در چند حوزه جدی دستهبندی کرد:

۱. کلاهبرداریهای مالی و باجگیریهای صوتی

تصور کنید تلفن شما زنگ میخورد و صدای فرزندتان را میشنوید که با گریه و التماس میگوید ربوده شده و برای آزادیاش به پول نیاز دارید. وحشتزده، هر کاری میکنید تا پول را فراهم کنید. اما در واقعیت، فرزند شما در کمال صحت و سلامت در مدرسه است و شما قربانی یک کلاهبرداری صوتی دیپفیک شدهاید. مجرمان با استفاده از نمونه کوتاهی از صدای فرزندتان (که شاید از شبکههای اجتماعی برداشتهاند)، توانستهاند صدای او را شبیهسازی کرده و شما را فریب دهند. این نوع کلاهبرداریها در حال افزایش است و میتواند خسارتهای مالی و روانی جبرانناپذیری به همراه داشته باشد.

۲. دستکاری افکار عمومی و نابودی دموکراسی

این همان سناریوی اول مقاله ماست. یک ویدیوی دیپفیک از یک نامزد انتخاباتی که حرفهای نژادپرستانه یا توهینآمیز میزند، میتواند درست چند روز قبل از انتخابات منتشر شود. تا زمانی که جعلی بودن ویدیو ثابت شود، کار از کار گذشته و رأیدهندگان تصمیم خود را گرفتهاند. این دیگر یک رقابت سالم نیست؛ این یک جنگ اطلاعاتی است که در آن حقیقت اولین قربانی است. وقتی شهروندان نتوانند به اطلاعاتی که میبینند و میشنوند اعتماد کنند، اساس دموکراسی، یعنی تصمیمگیری آگاهانه، از بین میرود.

۳. آزار و اذیت و پورنوگرافی انتقامجویانه

یکی از تاریکترین و شایعترین استفادههای دیپفیک، ساخت ویدیوهای مستهجن بدون رضایت افراد است. در این روش، چهره قربانیان (که عمدتاً زنان هستند) روی بدن بازیگران فیلمهای پورنوگرافی قرار میگیرد. این کار میتواند زندگی یک فرد را نابود کند، به آبروی او لطمه بزند و باعث آسیبهای شدید روحی شود. این یک تجاوز دیجیتال است که متأسفانه روزبهروز در حال گسترش است.

۴. فرسایش اعتماد عمومی: خطرناکترین تهدید

شاید بزرگترین خطر دیپفیک، تأثیر روانی آن بر جامعه باشد. وقتی هر ویدیویی میتواند جعلی باشد، ما به چه چیزی میتوانیم اعتماد کنیم؟ اگر فردا یک ویدیوی واقعی از فساد یک مقام مسئول منتشر شود، او به راحتی میتواند ادعا کند که آن ویدیو "دیپفیک" است و از زیر بار مسئولیت شانه خالی کند. این پدیده که به آن «سود سهام دروغگو» (Liar's Dividend) میگویند، باعث میشود که مردم دیگر به هیچ مدرک بصری اعتماد نکنند و حقیقت در میان انبوهی از شک و تردید گم شود.

چگونه یک دیپفیک را تشخیص دهیم؟ کارآگاه درون خود را بیدار کنید

خبر خوب این است که هنوز هم راههایی برای تشخیص دیپفیکها وجود دارد، هرچند روزبهروز سختتر میشود. در اینجا به چند نکته اشاره میکنیم:

- پلک زدن غیرطبیعی: مدلهای اولیه دیپفیک در شبیهسازی پلک زدن مشکل داشتند. شخصیتهای ویدیویی یا خیلی کم پلک میزدند یا اصلاً پلک نمیزدند.

- ناهماهنگی در چهره و احساسات: آیا چهره فرد بیروح به نظر میرسد در حالی که صدایش پر از هیجان است؟ آیا لبخندش مصنوعی است؟

- جزئیات عجیب در تصویر: به لبههای صورت، موها و گردن دقت کنید. گاهی اوقات ممکن است تاری یا اعوجاج غیرعادی در این قسمتها ببینید.

- نورپردازی و سایههای ناسازگار: آیا نوری که روی صورت فرد تابیده با نور محیط هماهنگ است؟

- صدای رباتیک یا ناهماهنگ: به صدای فرد گوش دهید. آیا کلمات به صورت بریدهبریده ادا میشوند یا لحن صدا یکنواخت و غیرطبیعی است؟

مهمترین نکته: همیشه به منبع خبر یا ویدیو شک کنید. قبل از باور کردن و به اشتراک گذاشتن یک محتوای جنجالی، از خود بپرسید: چه کسی از انتشار این محتوا سود میبرد؟ آیا رسانههای معتبر دیگر هم آن را پوشش دادهاند؟

بخش دوم: اخبار جعلی؛ کارخانه دروغپردازی با سوخت هوش مصنوعی

اگر دیپفیک یک قاتل حرفهای و دقیق است، اخبار جعلی (Fake News) مانند یک ارتش بیشمار از سربازان پیادهنظام عمل میکند. اخبار جعلی پدیده جدیدی نیست؛ در طول تاریخ همیشه شایعات و اطلاعات غلط وجود داشته است. اما هوش مصنوعی به این پدیده قدرتی بخشیده که هرگز در تاریخ سابقه نداشته است. این فناوری به تولیدکنندگان اخبار جعلی اجازه میدهد تا در مقیاسی وسیع، با سرعتی باورنکردنی و با تأثیرگذاری بسیار بیشتر، دروغهای خود را منتشر کنند.

هوش مصنوعی چگونه به یک ماشین تولید دروغ تبدیل میشود؟

هوش مصنوعی از سه طریق اصلی به ترویج اخبار جعلی کمک میکند:

۱. تولید انبوه محتوای دروغین

مدلهای زبانی پیشرفته هوش مصنوعی (مانند ChatGPT و موارد مشابه) میتوانند در عرض چند ثانیه، مقالاتی بنویسند که از نظر نگارشی کاملاً بینقص و از نظر محتوایی بسیار متقاعدکننده به نظر میرسند. یک عامل انسانی میتواند با دادن یک دستور ساده به هوش مصنوعی، هزاران مقاله، پست وبلاگ، یا کامنت در شبکههای اجتماعی با یک موضوع خاص (مثلاً بیفایده بودن یک واکسن خاص) تولید کند. این محتواها میتوانند به زبانهای مختلف ترجمه شده و در سراسر اینترنت پخش شوند و این تصور غلط را ایجاد کنند که یک بحث علمی واقعی در جریان است.

۲. ساخت ارتشی از رباتهای اجتماعی (Bots)

هوش مصنوعی میتواند هزاران پروفایل جعلی در شبکههای اجتماعی مانند توییتر، فیسبوک و اینستاگرام بسازد. این پروفایلها عکس، نام و بیوگرافی دارند و مانند کاربران واقعی رفتار میکنند. سپس این ارتش رباتها به صورت هماهنگ شروع به لایک کردن، بازنشر کردن و کامنت گذاشتن زیر اخبار جعلی میکنند. این کار باعث میشود که الگوریتمهای شبکههای اجتماعی فریب بخورند و فکر کنند که این خبر بسیار محبوب و مهم است، در نتیجه آن را به افراد بیشتری نشان میدهند. اینگونه است که یک دروغ کوچک، به سرعت تبدیل به یک ترند جهانی میشود.

۳. هدفگیری دقیق و روانشناختی مخاطبان

اینجاست که هوش مصنوعی واقعاً خطرناک میشود. پلتفرمهای آنلاین حجم عظیمی از اطلاعات درباره ما جمعآوری میکنند: سن، جنسیت، علایق، ترسها، باورهای سیاسی و حتی ضعفهای شخصیتی ما. تولیدکنندگان اخبار جعلی میتوانند با استفاده از هوش مصنوعی، این اطلاعات را تحلیل کرده و پیامهای دروغین خود را دقیقاً برای آسیبپذیرترین افراد ارسال کنند. برای مثال، اگر شما نگران وضعیت اقتصادی باشید، هوش مصنوعی میتواند اخبار جعلی درباره فروپاشی قریبالوقوع بانکها را به شما نشان دهد تا شما را به وحشت بیندازد. این یک دستکاری روانشناختی در مقیاس وسیع است.

چرا اخبار جعلی تا این حد خطرناک است؟

اخبار جعلی فقط چند دروغ ساده نیستند؛ آنها میتوانند پایههای یک جامعه را سست کنند:

- ایجاد تفرقه و قطبیسازی: اخبار جعلی با هدف قرار دادن احساسات ما (خشم، ترس، نفرت)، جامعه را به گروههای متخاصم «ما» و «آنها» تقسیم میکنند و گفتگوی سازنده را غیرممکن میسازند.

- آسیب به سلامت عمومی: اطلاعات غلط درباره درمانهای پزشکی یا واکسنها میتواند منجر به مرگ افراد شود. در دوران همهگیری کرونا، شاهد بودیم که چگونه اخبار جعلی باعث شد بسیاری از مردم از اقدامات پیشگیرانه خودداری کنند.

- تضعیف نهادهای دموکراتیک: حملات مداوم به اعتبار رسانهها، دانشمندان و دولتها باعث میشود که مردم به هیچکس و هیچچیز اعتماد نکنند و جامعه دچار هرجومرج شود.

بخش سوم: فراتر از دیپفیک و اخبار جعلی؛ تهدیدهای پنهان دیگر

خطرات هوش مصنوعی به این دو مورد ختم نمیشوند. تهدیدهای دیگری نیز وجود دارند که شاید کمتر به چشم بیایند، اما به همان اندازه نگرانکننده هستند.

۱. الگوریتمهای سوگیرانه و تبعیض سیستماتیک

هوش مصنوعی مانند یک کودک است؛ هرچه به او یاد بدهید، همان را یاد میگیرد. مشکل اینجاست که ما انسانها موجوداتی پر از سوگیری و پیشداوری هستیم و این سوگیریها در دادههایی که به هوش مصنوعی میدهیم، منعکس میشود. برای مثال:

- در استخدام: اگر یک سیستم هوش مصنوعی را با دادههای استخدامی ۳۰ سال گذشته یک شرکت آموزش دهیم که در آن عمدتاً مردان استخدام شدهاند، هوش مصنوعی یاد میگیرد که مرد بودن یک ویژگی مثبت برای استخدام است و به طور سیستماتیک رزومه زنان را رد میکند.

- در سیستم قضایی: برخی سیستمهای هوش مصنوعی برای پیشبینی احتمال ارتکاب مجدد جرم توسط یک متهم استفاده میشوند. تحقیقات نشان داده که این سیستمها به دلیل دادههای تاریخی مغرضانه، به اشتباه احتمال بیشتری برای ارتکاب جرم توسط سیاهپوستان پیشبینی میکنند.

این تبعیض دیجیتال بسیار خطرناک است، زیرا در پشت نقابی از عینیت و بیطرفی ریاضیاتی پنهان شده و مبارزه با آن بسیار دشوار است.

۲. سلاحهای خودکار مرگبار (قاتلهای رباتیک)

یکی از ترسناکترین چشماندازهای آینده، ساخت سلاحهایی است که توسط هوش مصنوعی کنترل میشوند و میتوانند بدون دخالت انسان، هدف را شناسایی کرده و تصمیم به کشتن بگیرند. این سلاحها که به آنها «سلاحهای خودکار مرگبار» (LAWS) یا «رباتهای قاتل» نیز گفته میشود، میتوانند مسابقه تسلیحاتی جدیدی را در جهان به راه بیندازند و ثبات جهانی را به خطر بیندازند. واگذاری تصمیم مرگ و زندگی به یک ماشین، یک خط قرمز اخلاقی است که بسیاری از دانشمندان و فعالان حقوق بشر درباره عبور از آن هشدار میدهند.

۳. بیکاری گسترده و نابرابری اقتصادی

انقلاب هوش مصنوعی با انقلاب صنعتی متفاوت است. این بار فقط کارگران کارخانهها نیستند که در خطر از دست دادن شغلشان هستند. هوش مصنوعی میتواند بسیاری از کارهای فکری را نیز انجام دهد: نوشتن متن، تحلیل داده، برنامهنویسی، و حتی طراحی. اگر برای این تحول عظیم آماده نباشیم، ممکن است با جامعهای روبرو شویم که در آن عده بسیار کمی که صاحب این فناوریها هستند، ثروت عظیمی به دست میآورند و بخش بزرگی از جامعه، شغل خود را از دست داده و به حاشیه رانده میشوند.

بخش چهارم: سپر ما در برابر تاریکی؛ چگونه از خود و جامعه محافظت کنیم؟

بعد از خواندن این همه خطر، ممکن است احساس ناامیدی کنید. اما هدف ما ترساندن نبود، بلکه آگاهسازی بود. خوشبختانه ما در برابر این تهدیدها بیدفاع نیستیم. راهکارهای مؤثری برای مقابله با جنبههای تاریک هوش مصنوعی وجود دارد که نیازمند تلاش همگانی از طرف افراد، شرکتهای فناوری و دولتها است.

۱. مهمترین سلاح: تفکر نقادانه

در دنیایی که هر چیزی میتواند جعلی باشد، قویترین ابزار ما، مغز ماست. باید یاد بگیریم که به مصرفکنندگان منفعل اطلاعات تبدیل نشویم. همیشه از خود بپرسید:

- منبع این خبر چیست؟ آیا یک وبسایت خبری معتبر است یا یک کانال تلگرامی ناشناس؟

- نویسنده چه هدفی داشته؟ آیا هدفش اطلاعرسانی است یا برانگیختن احساسات من (خشم، ترس)؟

*آیا منابع دیگری هم این خبر را تأیید میکنند؟ یک جستجوی ساده در گوگل میتواند به شما کمک کند.

- آیا این خبر بیش از حد خوب (یا بد) به نظر نمیرسد؟ معمولاً محتواهای بسیار جنجالی و احساسی، با هدف فریب طراحی شدهاند.

به حس درونی خود اعتماد کنید. اگر چیزی مشکوک به نظر میرسد، احتمالاً مشکوک است. آن را باور نکنید و مهمتر از همه، آن را برای دیگران ارسال نکنید.

۲. آموزش سواد رسانهای و دیجیتال

ما باید سواد رسانهای را مانند خواندن و نوشتن، از سنین پایین به کودکان خود آموزش دهیم. آنها باید یاد بگیرند که اینترنت چگونه کار میکند، الگوریتمها چه هستند، و چگونه اطلاعات درست را از نادرست تشخیص دهند. این یک مهارت حیاتی برای زندگی در قرن بیست و یکم است.

۳. مسئولیت شرکتهای فناوری و دولتها

ما به عنوان کاربران، نمیتوانیم به تنهایی با این مشکل مبارزه کنیم. شرکتهای بزرگی مانند گوگل، متا (فیسبوک)، و توییتر مسئولیت دارند که پلتفرمهای خود را از محتوای مضر پاکسازی کنند. آنها باید:

- محتوای تولید شده توسط هوش مصنوعی را برچسبگذاری کنند: کاربران باید بدانند که آیا در حال تماشای یک ویدیوی واقعی هستند یا یک دیپفیک.

- الگوریتمهای خود را اصلاح کنند: الگوریتمها نباید محتوای دروغین و تفرقهانگیز را ترویج دهند، حتی اگر این کار برایشان سودآور باشد.

- سرمایهگذاری روی ابزارهای تشخیص: آنها باید فناوریهایی را برای شناسایی خودکار دیپفیکها و اخبار جعلی توسعه دهند.

دولتها نیز باید با وضع قوانین شفاف و محکم، این شرکتها را ملزم به رعایت این استانداردها کنند و از شهروندان خود در برابر این آسیبها محافظت نمایند.

سخن پایانی: آیندهای که خودمان میسازیم

هوش مصنوعی نه یک هیولای شیطانی است و نه یک فرشته نجات. هوش مصنوعی یک آینه است؛ آینهای قدرتمند که بهترین و بدترین ویژگیهای ما انسانها را بازتاب میدهد. خطراتی مانند دیپفیک، اخبار جعلی و الگوریتمهای سوگیرانه، هشدارهایی جدی هستند که به ما میگویند باید با احتیاط و مسئولیتپذیری بیشتری در این مسیر قدم برداریم.

آینده هوش مصنوعی هنوز نوشته نشده است. این ما هستیم که با انتخابهای امروزمان، داستان فردا را مینویسیم. با افزایش آگاهی، تقویت تفکر نقادانه و مطالبهگری برای یک هوش مصنوعی اخلاقمدار، میتوانیم اطمینان حاصل کنیم که این فناوری شگفتانگیز در خدمت بشریت باقی میماند و به ابزاری برای ساختن یک دنیای بهتر، عادلانهتر و صادقانهتر تبدیل میشود. انتخاب با ماست.

میخواهید قدرت پرامپتنویسی خود را به سطح بعدی ببرید؟

با شرکت در دوره «جنگجوی پرامپتنویسی (از کلمات تا معجزه)»، یاد میگیرید چگونه با کلمات ساده، نتایج خارقالعاده در هوش مصنوعی خلق کنید.

سوالات متداول (FAQ)

در این بخش به برخی از سوالات رایج در مورد خطرات هوش مصنوعی پاسخ میدهیم.

این یکی از بزرگترین سؤالات در این زمینه است. هوش مصنوعی در انجام وظایف خاص و تکراری (مانند تحلیل داده یا حتی رانندگی) میتواند بسیار بهتر از انسان عمل کند و احتمالاً بسیاری از مشاغل را خودکار خواهد کرد. اما ویژگیهایی مانند خلاقیت واقعی، هوش هیجانی، همدلی و قضاوت اخلاقی هنوز هم منحصراً انسانی هستند. بنابراین، به جای جایگزینی کامل، محتملتر است که هوش مصنوعی به یک ابزار کمکی قدرتمند برای انسانها تبدیل شود و ماهیت کار ما را تغییر دهد.

اخبار جعلی (Fake News) به محتوای اطلاعاتی نادرست (معمولاً متن) اشاره دارد که با هدف فریب دادن مخاطب ساخته میشود. اما دیپفیک (Deepfake) یک تکنیک خاص است که از هوش مصنوعی برای ساخت ویدیو یا صوت جعلی استفاده میکند. به عبارت دیگر، دیپفیک میتواند یکی از ابزارهای بسیار قدرتمند برای ساخت و انتشار اخبار جعلی باشد، زیرا به دروغها ظاهری بسیار واقعی و مستند میبخشد.

لزوماً نه. سوگیری در هوش مصنوعی از دادههایی ناشی میشود که با آن آموزش دیده است. اگر دادههای ورودی کامل، متنوع و نماینده کل جامعه باشد، هوش مصنوعی میتواند بسیار عادلانه عمل کند. مشکل اینجاست که جمعآوری چنین دادههای بینقصی بسیار دشوار است. بنابراین، توسعهدهندگان هوش مصنوعی باید همواره نسبت به احتمال وجود سوگیری آگاه باشند و به طور فعال برای شناسایی و کاهش آن تلاش کنند.

تقریباً تمام پلتفرمهای بزرگ رسانههای اجتماعی (مانند یوتیوب، فیسبوک، اینستاگرام و توییتر) گزینههایی برای گزارش محتوای گمراهکننده یا جعلی دارند. معمولاً با کلیک روی سه نقطه (...) کنار پست، میتوانید گزینه "گزارش" (Report) را پیدا کرده و دلیل آن را "اطلاعات غلط" (False Information) یا "کلاهبرداری" (Scam) انتخاب کنید. گزارش کردن این محتواها به حذف آنها و جلوگیری از آسیب بیشتر کمک میکند.

اخبار جعلی (Fake News) به محتوای اطلاعاتی نادرست (معمولاً متن) اشاره دارد که با هدف فریب دادن مخاطب ساخته میشود. اما دیپفیک (Deepfake) یک تکنیک خاص است که از هوش مصنوعی برای ساخت ویدیو یا صوت جعلی استفاده میکند. به عبارت دیگر، دیپفیک میتواند یکی از ابزارهای بسیار قدرتمند برای ساخت و انتشار اخبار جعلی باشد، زیرا به دروغها ظاهری بسیار واقعی و مستند میبخشد.

دولتها در سراسر جهان به تدریج در حال درک این تهدیدها هستند. اقداماتی مانند تصویب قوانینی برای جرمانگاری ساخت و انتشار دیپفیکهای مخرب (بهویژه در حوزه پورنوگرافی) و الزام پلتفرمهای آنلاین به شفافیت بیشتر در حال انجام است. اتحادیه اروپا با «قانون هوش مصنوعی» (AI Act) یکی از پیشگامان در این زمینه است. با این حال، این حوزه هنوز جدید است و قوانین با سرعت کمتری نسبت به تکنولوژی پیش میروند.

ترس لزوماً واکنش درستی نیست. «احتیاط» و «آگاهی» کلمات بهتری هستند. ما نباید از خود فناوری بترسیم، بلکه باید نگران سوءاستفاده انسانها از آن باشیم. همانطور که یاد گرفتیم چگونه با خطرات سایر فناوریهای قدرتمند (مانند انرژی هستهای) کنار بیاییم، باید یاد بگیریم که برای هوش مصنوعی نیز چارچوبهای اخلاقی و قانونی محکم ایجاد کنیم. آینده هوش مصنوعی به جای ترسناک بودن، میتواند بسیار روشن باشد، به شرطی که ما آن را به درستی هدایت کنیم.

یکی از اولین نمونههای معروفی که توجهها را به خود جلب کرد، ویدیویی بود که توسط کارگردان جردن پیل ساخته شد و در آن باراک اوباما در حال گفتن جملاتی بود که هرگز به زبان نیاورده بود. هدف این ویدیو هشدار دادن درباره خطرات این فناوری بود. نمونه معروف دیگر، ویدیوهای سرگرمکنندهای از تام کروز است که در شبکه اجتماعی تیکتاک منتشر شد و کیفیت بسیار بالای آن بسیاری را شگفتزده کرد. در حوزه سیاسی نیز ویدیوهای جعلی از ولودیمیر زلنسکی، رئیسجمهور اوکراین، در حال اعلام تسلیم منتشر شد که به سرعت جعلی بودن آن مشخص گردید.

به این مطلب چه امتیازی می دهید؟

متوسط امتیاز / 5. تعداد امتیازدهندگان:

امتیازی ثبت نشده است! اولین نفری باشید که به این پست امتیاز می دهید.

بیشتر بخوانیم

پیشنهاد میکنیم این مقالات را هم بخوانید